[HCI] 인간의 편향(Human bias)과 AI

개요

‘인간은 모든 판단을 합리적이고 계산적으로 하는가?’라고 질문한다면, 아니라고 확실하게 대답 할 수 있을 것입니다. 인간은 기본적으로 편향을 가지고 판단하며, 헹동경제학은 인간의 편향성에 대한 이해를 도와줍니다. 인간의 데이터를 학습한 AI에도 편향이 발생할까요? 발생한다면 어떻게 다루어야 할까요? 이를 이해하기 위해 인간 편향 발생의 원인과 AI 편향을 다룬 다양한 연구에 대해 알아보도록 합시다.

인간은 불완전하다.

실제 효용과 체감 효횽이 다를 수 있다는 전망이론(Prospect theory)이 발표되었습니다. 전망이론은 사람들의 효용수준이 이익보다 손실에 더 민감하며, 특히 이익구간에서는 안전한 선택을 선호하게 된다고 주장합니다. S자 모양의 효용곡선에서 볼 수 있는 것처럼 여기에서 효용은 ‘기준점’을 기반으로 하므로, 이득이나 손실의 수준이 똑같더라도 어떤 기준점에서 측정하는가에 따라 느끼는 효용은 다르다는 것을 의미합니다.

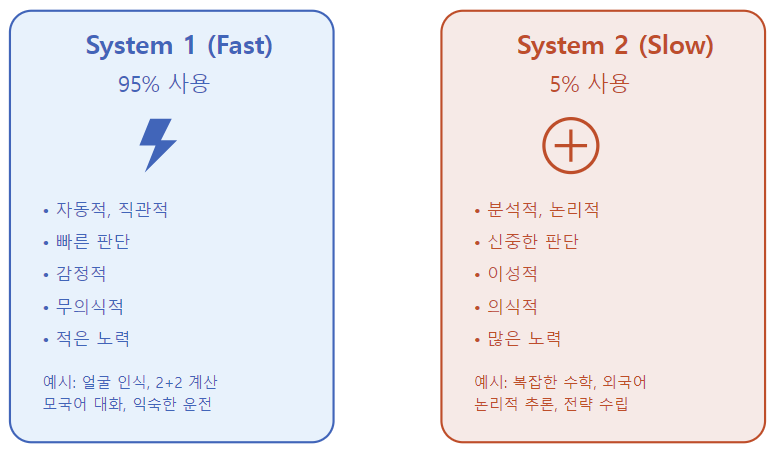

대니얼 카너먼은 인간이 왜 합리지 적이지 않은 선택을 그토록 많이 하는가에 대한 대답으로 빠른 사고(Thinking fast)와 느린 사고(Thinking slow)의 Dual System Theory를 제시하고, 관련 연구에 대해 자세히 소개했습니다.

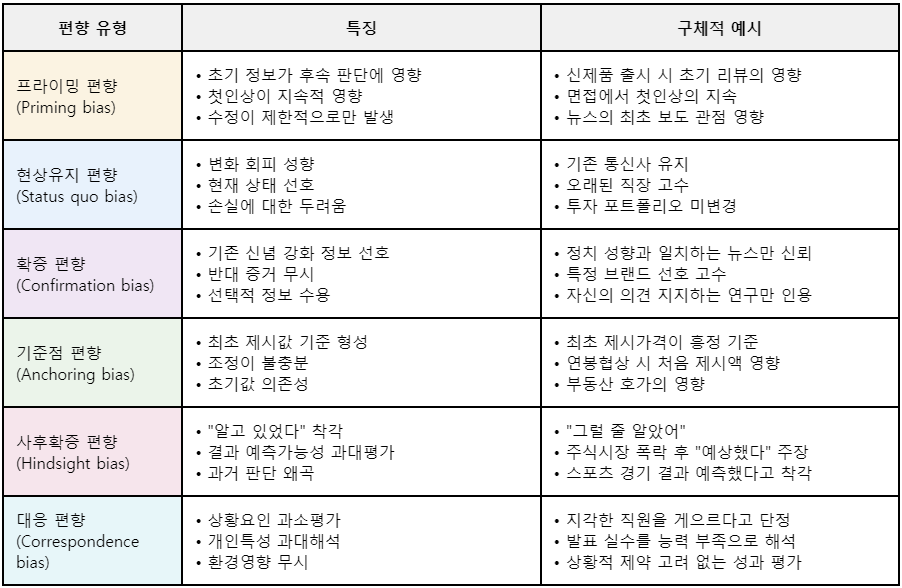

인간의 이성과 직관 그리고 편향

Asian Disease Problem(아시안 질병 문제)

600명이 죽을 수 있는 질병이 발생했다고 가정해봅시다. 여러분이 긍정적 프레임과 부정적 프레임 그룹 중 하나에 속했다고 가정 할 때, 질병 해결을 위한 두가지 프로그램 A,B가 주어집니다. 어떤 프로그램을 선택해야 할까요?

실험 결과, 긍정적 프레임 그룹의 72%가 Program A(확실하게 200명 살림)를 선택하고, 부정적 프레임 그룹의 78%가 Program B(2/3확률로 600명 죽음)를 선택했습니다. 두 프레임은 산술적으로 동일한 상황임에도 말이죠.

이유는 두 프레임의 부각된 정보의 차이라고 보여집니다. 첫 프레임은 ‘살린다’라는 긍정적 프레임이 강조되었고, 두번째 프레임은 ‘죽는다’는 관점이 부각되었습니다. 이 실험은 인간의 의사결정이 순수하게 합리적이지 않으머, 정보를 제시하는 방식에 크게 영향받는다는 것을 보여줍니다.

Prospect Theory(기대 이론)

다음 실험은 Prospect Theory 실험입니다. 여러분에게 우선 Game A/B가 선택권이 주어지고, 이어서 Game C/D 선택권이 주어진다고 가정합니다. 두 상황에서 각각 어떤 게임을 선택해야 가장 큰 수익을 얻을 수 있을까요?

실험 결과 A/B 선택에서 대부분의 사람들은 어떤 것을 선택해야 할지 어려워하다 A를 선택했고, C/D 선택에서는 쉽게 기대값이 높은 D를 선택했습니다. 두 선택 모두 합리적으로 보입니다.

하지만, 두 게임 모두 동일하게 후자의 기대값이 0.39 높습니다. A/B는 0.39의 차이를 보이고 마찬가지로 C/D도 0.39의 기댓값 차이를 보입니다. A/B 선택에서는 복잡합 확률 계산과 확실성이라는 심리적 요인이 충돌하면서 결정이 어려웠고, 확실한 이득을 선택했습니다. 반면, C/D 선택은 “어차피 잃을 것”이라는 심리 하에 더 단순한 판단이 가능했습니다. 이러한 현상은 확실한 것에 의미를 부여하는 인간의 본능과 맞닿아 있으며, 이성보다는 직관에 의존하기 때문에 발생하는 현상으로 볼 수 있습니다.

인간의 두 사고 시스템과 편향

카너만은 이러한 현상 설명을 위해, 인간에게 두 개의 시스템이 공존하고 있으며, 서로 다른 역할을 하고 있다고 제시합니다. 직관은 이성에 비해 더 자주 사용되며, 무의식적으고 빠르고 자동적으로 개입합니다. 그에 반해 이성은 직관에 비해서 의식적인 노력이 필요하며 매우 느립니다. 직관은 이성에 비해서 정확하지 못하지만, 인지적 자원을 적게 사용하기 때문에 빠르고 강하게 작용합니다. 이를 휴리스틱(Heuristics, 어림짐작)한 판단이라고 하며, 이는 인지적 편향(Cognitive bias)의 원인이 된다고 합니다.

AI 제품/서비스에서의 편향

앞서 인간이 편향적 사고를 가질 수 밖에 없는 이유에 대해 살펴봤습니다. 그렇다면 AI도 편향을 가질 수 있을까요? AI 활용 관점에서 편향은 어떤 이슈를 발생시킬까요? Roselli, D., Matthews, J., & Talagala, N은 “Managing bias in AI”에서 기업들이 AI 제품/서비스를 설계, 개발하면서 발생시킬 수 있는 여러 편향들에 대해서 정리했습니다.

1. 목표 설정 문제(Representing the problem)

대리 목표(Proxy Goals)

대리 목표를 정의하는 데 사용되는 역사적 데이터가 역사적 편향을 내포할 수 있습니다. 예를 들어 채용과정에서 “좋은 직원” 채용이라는 목표로 “승진자의 특성”과 유사한 지원자를 채용하고자 할 때, 과거 데이터가 남성 중심적인 경우 AI는 남성 = 좋은 직원이라고 학습할 수 있습니다.

특징 선택(Feature Selection)

특정한 특징을 선택하는 과정(특히 유용한 특징이 제외되는 경우)에서 편향이 발생할 수 있습니다. 예를 들어 질병 진단 AI에서 “생활습관”, “가족력” 등의 유용한 요인을 제외할 경우 중요한 맥락 정보 누락으로 잘못된 진단을 할 확률이 높아집니다.

대리 데이터(Surrogate Date)

대규모 수치 데이터 세트를 대리 데이터로 사용하면 정보 손실과 편향된 매핑을 초래할 수 있습니다. 예를 들어 학생의 학습 성과를 측정할 때, 학생의 실제 이해도가 아닌 “점수”, “과제 제출률” 등의 대리 데이터를 사용하면 편향이 발생할 수 있습니다.

2. 데이터셋(Datasets)

보지 못한 사례(Unseen Cases)

AI 시스템이 훈련 데이터에 없는 클래스와 맞닥뜨릴 경우 실패할 수 있습니다.

불일치 데이터셋(Mismatched Datasets)

훈련 데이터와 실제 데이터 간의 차이는 성능 저하를 초래할 수 있습니다.

조작된 데이터(Manipulated Data)

훈련 데이터가 의도적으로 왜곡될 수 있습니다.

일반화가 불가능한 특징 및 관련 없는 상관관계(Non-Generalizable Features and Irrelevent Correalations):

특징 훈련 세트에 특화된 특징이나 관련 없는 상관관계가 AI 예측을 잘못 이끌 수 있습니다.

3. 개별 샘플(Individual Samplse)

부정확한 데이터(Inaccurate Data)

실제 데이터가 불완전하거나 잘못될 수 있습니다.

오래된 데이터(Stale Data)

오래된 데이터가 AI 성능에 영향을 줄 수 있습니다.

편향 관리 방안

(5가지 추가)

편향 최소화를 위한 가이드라인

1. 시작할 때 가이드라인

- 시스템이 할 수 있는 일을 사용자에게 명확히 설명한다.

- 시스템이 할 수 있는 일의 성능을 명확히 설명해, 정확성과 신뢰성을 사용자에게 전달한다.

2. 상호작용 중 가이드라인

- 사용자 맥락에 따라 서비스 제공 시기를 결정한다.

- 현재 작업이나 상황과 맥락적으로 관련 있는 정보를 표시한다.

- 관련된 사회적 규범에 맞춰 행동하도록 한다.

- 사회적 편견을 완환하도록 한다.

3. 잘못된 결과 발생 시 가이드라인

- 사용자가 시스템 기능을 쉽게 활성화 할 수 있도록 한다.(효율적 호출 지원)

- 사용자가 시스템 기능을 쉽게 비활성화 할 수 있도록 한다.(효율적 해제 지원)

- 사용자가 시스템의 오류를 쉽게 수정할 수 있도록 한다.(효율적인 수정 지원)

- 사용자의 목표가 확실 할 때, 시스템의 작업 범위를 제한한다.(불확실한 서비스 범위 제한)

- 시스템의 행동과 결정에 대한 설명을 제공한다.(시스템이 한 일을 명확히 설명)

4. 사용 중 가이드라인

- 과거 상호작용을 사용하여 미래 행동을 결정한다.

- 사용자 행동을 바탕으로 시스템을 개인화한다.(사용자 행동 학습)

- 시스템 행동을 업데이트 하거나 적용할 때 방해를 최소화 하도록 한다.(신중한 업데이트 적용)

- 사용자로부터 상세한 피드백을 받을 수 있도록 한다.(피드백 장려)

- 사용자 행동이 시스템에 미칠 영향을 명확히 전달하도록 한다.(사용자 행동 전달)

- 사용자가 시스템의 모니터링 및 행동 방식을 제어할 수 있도록 한다.(글로벌 제어)

- 시스템의 기능 추가나 업데이트에 대해 사용자에게 알린다.(변경 사항 알림)

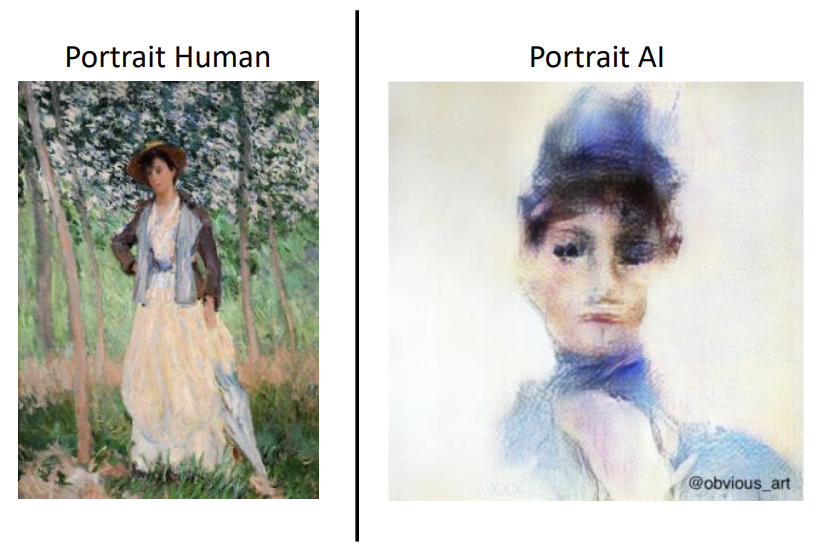

AI 예술 작품에 대한 인식 편향

이 연구에서는 생성적 적대 신경망(GAN)을 통해 인공지능이 예술 분야 미친 영향을 연구했습니다. 565명 참가자를 대상으로 AI 그림과 인간의 그림을 네 가지 차원에서 평가하도록 했고, 실험 결과 사람들이 AI가 만든 것으로 인지한 그림보다 인간이 만든 것으로 인식한 그림을 더 높게 평가하는 경향이 있음을 발견했습니다.

흥미로운 점은 사람들은 결과물이 실제로 사람이 만든 것인지 AI가 만든 것인지 실제로는 잘 구분할 수 없었음에도 불구하고 이러한 인식의 차이를 나타냈다는 점입니다.